こんにちは。だんさんです。

本日は、レコメンド分野への応用も期待できる論文「Large Content And Behavior Models To Understand, Simulate, And Optimize Content And Behavior(2024)」について紹介いたします。

本論文はLLM(Large Language Model)ならぬ、LCBM(Large Content And Behavior Model)として論文が発表されました。機械学習のトップカンファレンスの一つであるICLR 2024にて発表が予定されているようです。

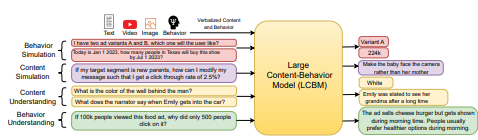

さて、本題に戻り本論文ですが、従来のLLMの手法とは異なり、コンテンツだけでなく、人々がどのようにそれらのコンテンツとやり取りするかについての情報も学習する点が特徴です。

具体的には、LLMの学習コーパスに、シェア、いいね、クリック、購入、リツイートなどの受信者の「行動トークン」を導入することで、受信者のためにコンテンツを最適化しその行動を予測する事が特徴として挙げられています。

既存のLLMを用いたモデルでは、いわゆるコンテンツの理解や、生成、表示まではとても満足のいく結果が生まれています。

コンテンツには、表示された後、再生されるかどうか、いいねされるかどうかのようないわゆる”行動”が不随します。

LLMは膨大な量のテキストを学習させている為、コンテンツの理解や生成は得意だが、その後の行動については学習段階では含まれていないそう。(参照:Pythia (Biderman et al., 2023))

その為、本論文ではその学習過程の中にコンテンツへの反応(いいねやシェア等)を予測できる状態にするために行動も学習に使ってモデルを作ることにより、そのコンテンツに対する人間の行動も推論し、予測できる可能性を示しています。

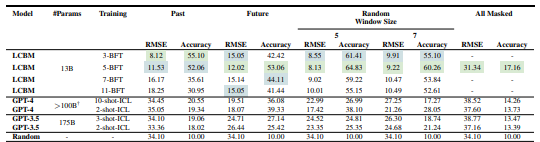

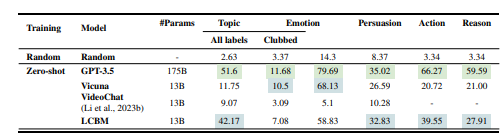

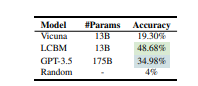

実際、論文内では、内容の理解はGPT-3.5の方か性能が良かったが、行動シミュレーションにまで広げると大きくLCBMの方に優位性が認められている。

※1Behavior Simulation

※2REMAINING TABLES AND FIGURES

さて、本題に戻りレコメンド領域への応用の可能性だが、すでに指し示されているようにテキストへの反応を学習へ用いることにより精度を上げるという行動はレコメンドにも応用できると考えます。

また、本論文の魅力的な部分として、パラメーター数が少ない上で予測精度が高いという状態が作れています。

Content Simulation

これにより、レコメンド領域あるあるの「精度が高い推論ができたが、実運用を考えると計算コストの観点から古典的手法を用いた方が結果的にコスパが良い」事への打開策になることも期待します。

本記事はレコメンドに興味がある一般人目線での考察や読解であり、専門領域として研究している者ではないので、間違いや捉え違い、不的確な表現が含む場合がございます。もしそれらを見かけましたら、コメントや連絡先のほうまでお伝えください。

本記事がレコメンド領域を勉強したい方への手助けとなれば幸いです。